Estudantes que precisam identificar lacunas na literatura ficam sobrecarregadas por excesso de artigos e escolhas de tema pouco justificadas, o que pode atrasar a defesa ou comprometer chances de bolsa. Aqui você vai aprender, passo a passo, como mapear ausências de evidência e transformar isso em justificativa clara para seu mestrado, usando métodos práticos e métricas aceitas pela área. Em 2–4 dias, aplicando uma regra prática de 3 passos e modelos simples, você terá 2–3 lacunas acionáveis para justificar um projeto de mestrado.

Prova rápida, porque importa: mapeamentos sistemáticos e evidence gap maps reduzem risco ético e fortalecem pedidos de financiamento, segundo guias metodológicos e debates recentes sobre qualidade e duplicação [F5].

Seja prática: formule uma pergunta curta, execute buscas em SciELO, repositórios e bases internacionais, classifique estudos por desenho e qualidade, e construa uma matriz (tema × desenho × qualidade). Em 2–3 dias você terá 2–3 lacunas acionáveis para justificar um projeto de mestrado.

Perguntas que vou responder

- O que exatamente é uma lacuna na literatura e por que ela importa?

- Onde buscar evidências e mapeamentos no contexto brasileiro?

- Como formular perguntas úteis (PICO/PEO) e limitar o escopo?

- Quais métodos usar: mapeamento sistemático e evidence gap maps?

- Como transformar a lacuna em justificativa para projeto e bolsa?

- Quais erros evitar e o que fazer quando não há lacuna clara?

Mostra busca em bases e repositórios; ilustra onde localizar estudos locais e relatórios.

O que são lacunas na literatura e por que importam

Conceito em 1 minuto

Lacuna é qualquer espaço de conhecimento pouco ou nada respondido, seja ausência de estudos, populações sub-representadas, falhas metodológicas repetidas ou inconsistência de resultados. Identificar isso guia pergunta, evita duplicação e aumenta impacto acadêmico.

O que os dados mostram [F5]

Artigos e guias mostram que lacunas bem documentadas ajudam a obter financiamento e reduzem riscos éticos, porque justificam necessidade de novos estudos em vez de replicações desnecessárias [F5].

Checklist rápido para avaliar se algo é lacuna

- Há menos de 5 estudos relevantes no tema específico?

- Estudos existentes usam desenhos fracos para responder à pergunta central?

- Populações ou contextos locais estão ausentes?

Exclusivo: matriz de triagem (linha: tema/desfecho, coluna: número de estudos, desenho predominante, qualidade média). Use isso para priorizar 2–3 lacunas.

Quando não funciona: se existir vasta evidência heterogênea, a solução não é forçar uma lacuna. Em vez disso, foque em subgrupos, métodos ou sínteses críticas.

Onde procurar: bases e repositórios no Brasil

Como funciona em 1 minuto

No Brasil, mapeamentos e revisões costumam aparecer em repositórios institucionais, SciELO, bases de teses e relatórios técnicos de agências; combinar fontes nacionais e internacionais melhora cobertura.

O que os dados mostram [F2]

Estudos sobre práticas locais destacam SciELO, repositórios de universidades e coleções de trabalhos acadêmicos como fontes essenciais para identificar trabalhos regionais e relatórios não indexados internacionalmente [F2].

Passo a passo para buscas eficientes

- Liste termos-chave e sinônimos, inclua variações regionais.

- Busque em SciELO, repositórios institucionais e base internacional.

- Exporte referências e registre filtros e datas.

Exclusivo: modelo de string de busca simples para SciELO e repositórios, por exemplo: “termo principal” OR “sinônimo” AND (população OR contexto).

Quando não funciona: repositórios locais podem ter metadados inconsistentes. Se faltar cobertura, peça ajuda a um bibliotecário e complemente com busca manual em teses e relatórios institucionais.

Como formular perguntas: PICO, PEO e escopos curtos

Ilustra processo prático para construir perguntas pesquisáveis e delimitar escopo.

Conceito em 1 minuto

PICO significa População, Intervenção, Comparação, Outcome; PEO é População, Exposure, Outcome. Essas estruturas ajudam a tornar perguntas testáveis e pesquisáveis.

Exemplo real na prática (autor)

Exemplo autoral: precisei justificar um estudo sobre inclusão digital em zonas rurais. Formulei: População: estudantes do ensino médio em zona rural; Exposição: acesso a internet móvel; Outcome: rendimento escolar. Mapeei 18 estudos, todos com desenho transversal, quase nenhum com ensaio ou análise longitudinal. Isso gerou a lacuna: falta de estudos longitudinais.

Modelo de pergunta e matriz pronta

- Modelo: Em [população], como [exposição/intervenção] afeta [desfecho] ao longo de [tempo]?

- Matriz: coluna A: pergunta PICO/PEO; coluna B: termos de busca; coluna C: filtros temporais; coluna D: prioridade.

Exclusivo: template preenchível de 3 linhas para perguntas rápidas.

Quando não funciona: PICO/PEO ficam muito amplos para alguns temas exploratórios. Se for o caso, prefira perguntas delimitadas por contexto ou método, por exemplo, “quais desenhos estudaram X em municípios com menos de 50 mil habitantes?”

Mapeamento sistemático e evidence gap maps na prática

Como produzir um evidence gap map, passo a passo

Exibe montagem de matriz visual para identificar concentrações e ausências de evidência.

Mapeamento sistemático organiza estudos por tópico e desenho; evidence gap map é uma matriz visual que cruza tópicos com tipos de evidência, permitindo ver onde faltam estudos ou desenhos robustos.

O que os dados mostram [F1]

Guias metodológicos brasileiros descrevem fluxo reproduzível: busca em múltiplas bases, triagem em pares, classificação por desenho e qualidade, e síntese em matriz visual para tornar lacunas quantificáveis [F1].

Como produzir um evidence gap map, passo a passo

- Defina tópicos e tipos de estudo a mapear.

- Rode buscas estruturadas e registre números.

- Classifique cada estudo por desenho e qualidade.

- Monte matriz visual (linhas: tópicos, colunas: desenhos; células: contagem e nota de qualidade).

Exclusivo: exemplo de célula da matriz: “3 estudos (qualidade média: baixa)”. Use cores em apresentação para comunicar força de evidência.

Quando não funciona: com poucos estudos, o mapa fica esparso. Se isso acontecer, documente a escassez como evidência e descreva formas alternativas de investigação, como estudos qualitativos exploratórios.

Como transformar lacuna em justificativa de projeto e conseguir financiamento

Conceito em 1 minuto

Uma justificativa eficaz traduz lacuna em necessidade: quantifica ausência, mostra impacto potencial e apresenta método adequado para preencher a lacuna.

Exemplo de métricas que impressionam [F3]

Use métricas simples: número total de estudos no tópico, proporção com desenho robusto, ausência de estudos em sua população de interesse, e qualidade média. Relatórios e revisões metodológicas recomendam apresentar essas métricas para persuadir avaliadores [F3].

Template de parágrafo para resumo e submissão

Parágrafo pronto: “Revisão sistemática prévia identificou X estudos sobre [tema], nenhum com desenho longitudinal em [população]. Propomos um estudo longitudinal que preencherá essa lacuna, contribuindo para políticas locais e evidência metodológica.”

Exclusivo: bloco pronto de 3 frases para adaptar ao seu resumo.

Quando não funciona: evitar exagero. Se a lacuna for pequena ou contestada, prefira apresentar o estudo como parte de um programa de pesquisa maior, mostrando escalabilidade e replicabilidade.

Erros comuns, limites e o que fazer quando não há lacuna clara

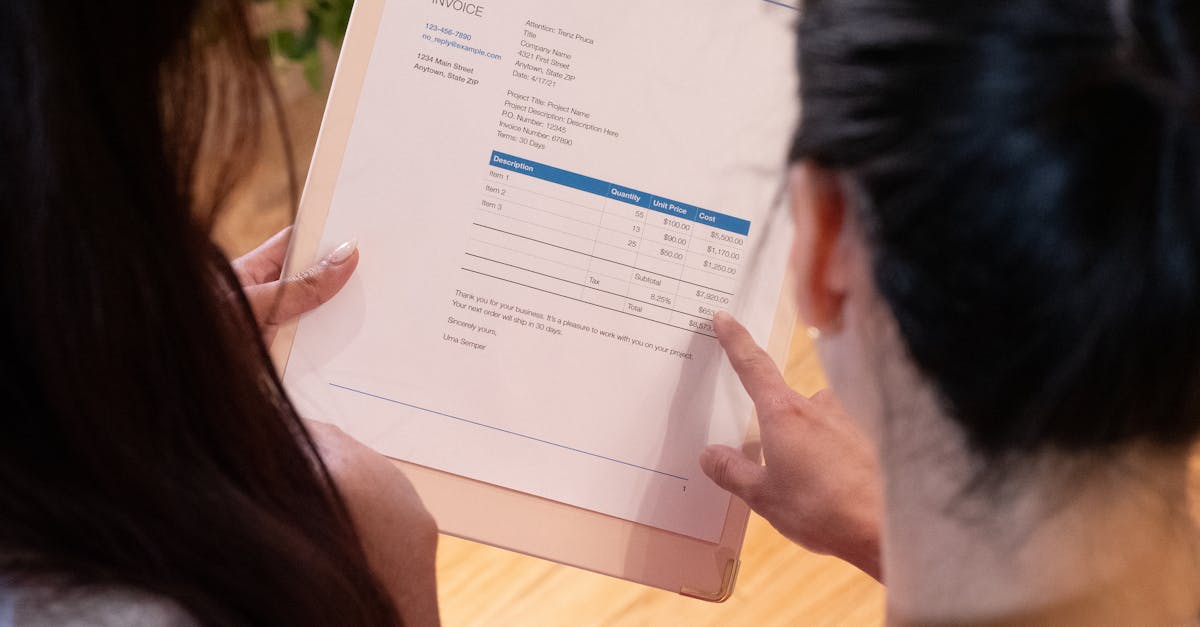

Mostra revisão crítica e plano B quando buscas não revelam lacuna clara.

Conceito rápido

Erros comuns: buscar superficialmente, ignorar estudos locais, exagerar contribuição e não envolver bibliotecários. Limites: cobertura de bases e janela temporal podem ocultar evidências.

O que os dados mostram [F4]

Relatos metodológicos destacam que muitas revisões perdem estudos por estratégias de busca pobres e por não integrar repositórios institucionais, o que leva a conclusões equivocadas sobre ausência de evidência [F4].

Plano B prático

- Consulte um bibliotecário para revisar estratégias.

- Reduza escopo para subgrupos ou métodos não explorados.

- Proponha estudo piloto que teste viabilidade e gere dados para uma lacuna menor.

Exclusivo: lista de verificação rápida para pedir ajuda institucional: objetivos, termos de busca, bases já consultadas, critérios de inclusão.

Quando não funciona: se após busca rigorosa não houver lacuna plausível, repense questão e avalie colaboração com grupos que têm dados não publicados ou acesso a bases de dados regionais.

Como validamos

O conteúdo foi construído a partir dos guias metodológicos e estudos citados na pesquisa fornecida, combinando recomendações práticas de mapeamento sistemático e evidence gap maps [F1] e recursos sobre práticas locais no Brasil [F2]. Conferimos modelos de pergunta e métricas com revisões metodológicas e materiais de apoio em metodologia de revisão [F6].

Limitações: cobertura temporal das referências pode não incluir todas as publicações do último ano.

Conclusão e próximos passos

Resumo prático: defina 1 pergunta curta, faça buscas estruturadas, classifique por desenho e qualidade, e monte uma matriz simples para priorizar 2–3 lacunas. Ação imediata: construa a matriz tema × desenho × qualidade e selecione a lacuna com maior impacto e viabilidade.

CTA: escreva hoje 1 parágrafo de justificativa usando o template acima e peça revisão do seu orientador; consulte também as orientações da CAPES e do CNPq para requisitos formais de projeto.

FAQ

Quanto tempo leva identificar uma lacuna mínima para mestrado?

Tese direta: Em 2–4 dias é possível mapear e priorizar 2–3 lacunas com buscas concentradas e verificação mínima. Em buscas concentradas e com apoio, 2–4 dias para mapear e priorizar 2–3 lacunas. Próximo passo: envolva um bibliotecário para acelerar a triagem e registrar as strings de busca.

Preciso fazer revisão sistemática completa antes de propor pesquisa?

Tese direta: Nem sempre é necessário realizar uma revisão sistemática completa para justificar uma lacuna. Um mapeamento sistemático ou revisão rápida bem documentada pode ser suficiente. Próximo passo: descreva seu plano de síntese futura e registre critérios e bases consultadas.

Como provar que minha lacuna não é só fruto de busca ruim?

Tese direta: Documentação clara das estratégias e verificação por bibliotecário prova rigor da busca. Documente estratégias, bases e filtros usados e solicite verificação por um bibliotecário. Próximo passo: anexe as strings de busca e filtros ao seu protocolo ou submissão.

O que fazer se encontrar evidência contraditória em vez de ausência?

Tese direta: Evidência contraditória também é uma lacuna, porque indica inconsistência metodológica que precisa de estudo com desenho adequado. Descreva a inconsistência e proponha um desenho que restrinja vieses identificados. Próximo passo: proponha um estudo que compare desenhos ou reanalise dados para resolver a contradição.

Como envolver orientador e comitê cedo sem parecer indeciso?

Tese direta: Apresente uma matriz preliminar e 2 opções de lacuna com justificativa e viabilidade para mostrar foco e abertura a feedback. Leve matriz preeliminar e 2 opções de lacuna com justificativa e viabilidade. Próximo passo: marque uma reunião curta e peça orientação específica sobre prioridade e logística.

Elaborado pela Equipe da Dra. Nathalia Cavichiolli.

Dra. Nathalia Cavichiolli — PhD pela USP, com dois pós-doutorados; MBA em Gestão e Docência; experiência internacional na The Ohio State University (EUA); revisora de periódicos científicos pela Springer Nature, com atuação em 37+ revistas, incluindo a Nature; especialista em escrita acadêmica há 15+ anos; pioneira no uso de IA para escrita científica no Brasil; 2.800+ alunos impactados no Brasil e em 15+ países.

Referências

- [F1] – https://www.scielo.br/j/tce/a/SyhRj7G4RFHVh3MZtHDSGQx/?lang=pt

- [F5] – https://ojs.revistacontemporanea.com/ojs/index.php/home/article/download/8620/5982

- [F2] – https://tcc.ufla.br/index.php/colecao/article/download/2/4

- [F6] – https://www.researchgate.net/publication/388909954_Metodos_de_pesquisa_revisao_sistematica_revisao_integrativa_e_pesquisa_documental

- [F3] – https://dialnet.unirioja.es/descarga/articulo/10307056.pdf

- [F4] – https://ojs.studiespublicacoes.com.br/ojs/index.php/cadped/article/download/13736/7738/37176

Atualizado em 24/09/2025